APRÈS le Web 2.0, voici venue l’ère du Big Data. Apparu à la fin des années 2000, le Big Data est devenu en moins de temps qu’il n’en faut pour le dire le roi des superlatifs au royaume du numérique. Le terme fait référence au volume de données gigan- tesques créées par tout un chacun. Pour citer la société IBM, « chaque jour, nous générons 2,5 trillions d’octets de données. À tel point que 90 % des données dans le monde ont été créées au cours des deux dernières années seulement. » Chaque heure, cinq milliards de mails sont envoyés ; chaque minute, cent heures de vidéo sont mises en ligne sur YouTube ; chaque seconde, 2 263 photos sont postées sur Facebook. D’où la naissance du Big Data, phénomène qui se caractérise par les 3 V : volume (quantité exponentielle), vélocité (prolifération très rapide), variété (multiplication des formats : textes, vidéos, sons…). Devant cette masse gigantesque de données, le cerveau humain ne peut plus faire face. Impossible de se représenter l’ensemble des documents, ni même de les consulter un à un. Impossible de continuer à les analyser avec les méthodes d’hier : il faut concevoir des outils capables de retrouver en temps réel, au moment où les données sont générées, l’aiguille dans la botte de foin ; développer des algorithmes susceptibles de scruter les moindres faits et gestes du web pour en tirer informations, connaissances, tendances… ou encore proposer un livre susceptible de retenir l’attention sur Amazon. Car le marketing, mais aussi l’analyse des risques ou encore l’épidémiologie sont directement concernés par le Big Data. La culture également. Lev Manovich, l’un des chercheurs les plus réputés dans le domaine de l’art et des nouveaux médias, se consacre depuis 2005 aux « cultural analytics »1, soit l’analyse et la visualisation de masses de données constituées essentiellement d’images et de vidéos. Selon lui, « la numérisation de grands ensembles d’artefacts issus du passé et l’essor des réseaux sociaux dans les années 2000 permettent de renouveler l’étude des processus culturels »2. Les études de cas concernent autant la totalité des œuvres de Mondrian ou de Rothko que les jeux vidéo ou encore l’évolution graphique des couvertures de Time Magazine depuis sa création. L’enjeu est ni plus ni moins de reconsidérer ce que nous entendons par « culture », ainsi que les méthodes employées dans ce champ.

Au théâtre, le Big Data en est officiellement à ses débuts. La première conférence portant explicitement sur le sujet a eu lieu le 9 novembre 2013 dans le cadre du colloque de l’American Society of Theatre Research. Intitulée « Big Data and the Performing Arts », elle est le fait de Doug Reside, conservateur au Département des arts de la scène à la New York Public Library. La conférence concerne essentiellement les archivistes et les chercheurs, lesquels sont confrontés au Big Data des collections et des fonds d’archives numérisés, ou encore aux disques durs des artistes dont ils doivent identifier, archiver et analyser les milliers de données3.

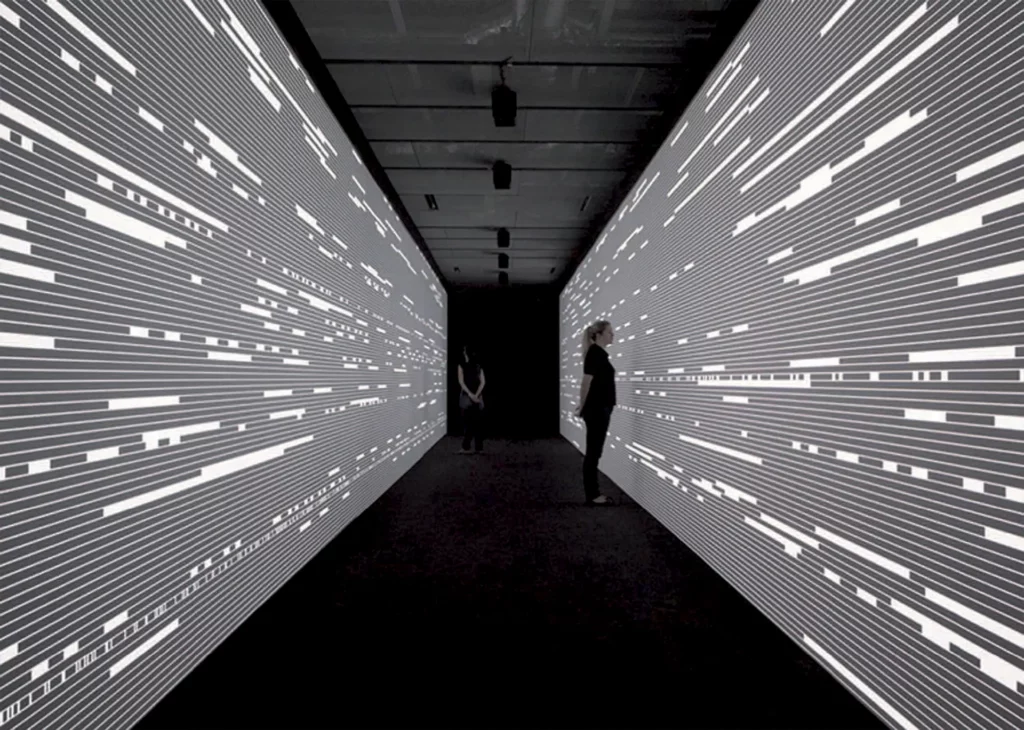

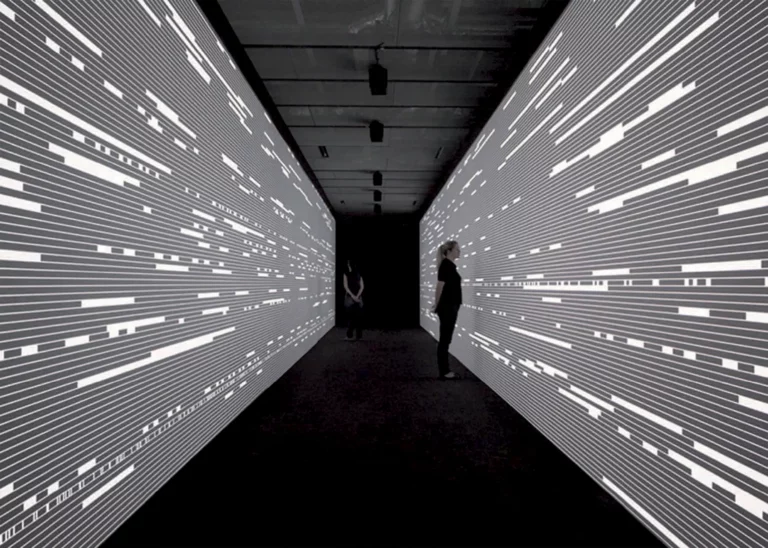

Impossible donc de se soustraire au Big Data, y compris pour les metteurs en scène et les chorégraphes contemporains, lesquels doivent se confronter à cet infini de la représentation, à cette représentation de l’infini. Des outils de visualisation de cette matière à la croissance inexorable sont conçus, qui permettent l’accès, en un seul coup d’œil, à des milliers de documents assemblés sous forme de graphes, de cartographies, qu’il faut démesurément agrandir pour atteindre une donnée isolée. Lev Manovich a recours au plus grand écran disponible dans le monde, le HIPerSpace (pour « Highly Interactive Parallelized Display Space »), lequel mesure 9,66 mètres de long par 2,25 mètres de hauteur pour une résolution de 35,840 x 8,000 pixels. Sur cet écran, il est possible de télécharger simultanément 10 000 images et de les agencer entre elles en temps réel en fonction de différents critères.

S’il n’est pas énoncé comme tel, le Big Data innerve en filigrane de nombreuses œuvres théâtrales. Deux courants sont identifiables : l’un du côté de la génération de spectacles, de textes, de créations sans fin, ou plutôt de machines à produire des œuvres aux variations illimitées ; l’autre du côté de la sélection, de la circulation dans un enchevêtrement de documents qu’il faut sélectionner, classer, connecter pour mieux les mettre en scène, ou encore de la navigation numérique comme embrayeur de dispositifs narratifs.

La génération ou la fabrique de l’illimité

De la première catégorie ressortissent les œuvres génératives qui reposent sur des programmes susceptibles d’engendrer des textes-représentations à l’infini. Les algorithmes génératifs permettent d’obtenir des résultats imprévisibles à partir de paramètres définis. Autrement dit, il incombe au metteur en scène de définir les paramètres, et à la machine d’en proposer une combinaison inédite. Dans le jeu des probabilités, peu de chance d’être confronté à une combinaison déjà expérimentée, d’où le sentiment d’un nombre infini de représentations possibles. Le rôle de l’auteur-metteur en scène est de concevoir le programme, et non le texte ou le son perçus lors de la représentation. Il n’écrit pas les spectacles vus par le spectateur, mais leur matrice, leur modèle, au sens mathématique du terme, c’est-à-dire une abstraction. Il définit l’algorithme − les règles du jeu − élabore les bases de données et choisit les objets qu’elles contiennent. Chaque représentation est une actualisation du modèle, soit une combinaison unique et éphémère de différents éléments. Dans une œuvre générative, la multiplicité des représentations est déjà contenue dans le programme.

L’un des premiers artistes à avoir expérimenté ce type d’écriture au théâtre est Jean-Pierre Balpe, auteur de plusieurs générateurs de textes qu’il conçoit comme des « ensemble[s] d’algorithmes pouvant gérer des variables qui, à partir d’un état donné, produisent un nombre infini d’applications ».4 Dès 1997, à l’IRCAM, il crée TROIS MYTHOLOGIES ET UN POÈTE AVEUGLE en collaboration avec le compositeur Jacopo Baboni-Schilingi et les poètes Henri Deluy et Joseph Guglielmi. Ce spectacle repose sur deux générateurs, l’un de texte (poésie), l’autre de musique. L’année suivante, Jean-Pierre Balpe initie BARBE-BLEUE avec le vidéaste Michel Jaffrennou et le compositeur Alexander Raskatov. Ce projet d’opéra numérique reposait sur trois générateurs : texte (pour le livret et les dialogues), son (pour la musique) et image (pour la scénographie). Tous les éléments du spectacle devaient être générés, de sorte que chaque représentation fut inédite. Il n’a pas pu être mené à terme mais, à chaque lancement de BARBE-BLEUE c’est une nouvelle représentation qui aurait eu lieu, unique et différente des autres représentations.

« Un nombre infini d’applications » : tel est le but d’ALIS (Association Lieux Images et Sons), compagnie dirigée par Pierre Fourny. Les spectacles et les installations d’ALIS reposent sur la déconstruction des signes, en particulier des signes linguistiques. La conception de la police « coupable » cristallise cette réflexion. Chaque lettre est coupée par un trait horizontal. Les deux parties ainsi obtenues sont communes avec de nombreuses autres lettres. Ce procédé permet de combiner ensuite des moitiés de mots entre eux, provoquant des glissements sémantiques dans ce qu’ALIS nomme des « poésies à 2 mi-mots » ou encore des « micro- spectacles ». Les combinaisons de la police coupable ont lieu dans le temps, sur l’espace noir de l’écran, ou encore sur des papiers découpés et autres artefacts manuels.Ce qui est donné à voir, c’est la coupure, et la transformation du sens des mots qu’elle engendre : « droite » devient « orbite» ; « gauche » cache « courbe» ; de « ciel » se détache « clef»… Un logiciel, CombinALISons, permet à Pierre Fourny de jouer des 400 000 mots de la langue française et de leurs combinatoires, de voir quels sont les mots cachés dans tel vocable pour ensuite en faire surgir des poèmes-spectacles : LA LANGUE COUPÉE EN 2 (2001), LA COUPURE (2008), L’ÂME HORS DU SIGNE (2011). Une nouvelle version du logiciel est en cours de développement en collaboration avec Serge Bouchardon à l’Université de Technologie à Compiègne (UTC) dans le cadre du projet intitulé « La séparation ».

- http://lab.softwarestudies.com/ ↩︎

- http://lab.softwarestudies.com/2008/09/cultural-analytics.html ↩︎

- L’expérience que je mène actuellement avec la création du logiciel Rekall est une tentative de réponse à ces problématiques. Rekall est un environnement open-source pour documenter, analyser les processus de création et simplifier la reprise des œuvres. ↩︎

- Balpe Jean-Pierre, TROIS MYTHOLOGIES ET UN POÈTE AVEUGLE, 1997, http://hypermedia.univ-paris8.fr/Jean-Pierre/articles/Creation.html ↩︎

- Myriam Gourfink, This is My House, 2005, programme de salle. ↩︎

- Fouilhoux Biliana, « Le surgissement créateur dans le processus de création chorégraphique. Improvisation entre prévisible et imprévisible », in LE SURGISSEMENT CRÉATEUR : JEU, HASARD ET INCONSCIENT, Paris, Édition Universitaire de la Sorbonne Paris V, 2011, p. 114. ↩︎

- Ryoji Ikeda, DATAMATICS, dossier de presse, Festival d’Automne à Paris 2008. ↩︎

- Ryoji Ikeda, SUPERPOSITION, dossier de presse, Festival d’Automne à Paris 2012. ↩︎

- D’une Théorie DE LA PERFORMANCE À VENIR OU LE SEUL MOYEN D’ÉVITER LE MASSACRE SERAIT-IL D’EN DEVENIR LES AUTEURS ? se compose de trois spectacles : I AM 1984 (2008), TRACKS (2009) et Forecasting (2011). ↩︎